Geoffrey Hinton: «Existe el 50 por ciento de posibilidades de que esto acabe mal. Yo no me subiría a un taxi si supiera que la mitad de sus viajes acaban en muerte»

Tiene 76 años y acaba de recibir el Nobel de Física. Lo llaman 'el padrino de la inteligencia artificial' porque sin su visionario trabajo no existirían ni ChatGPT ni los otros chatbots que están revolucionando el mundo. Ahora, sin embargo, ha dejado Silicon Valley para advertirnos: estamos creando un monstruo que amenaza la humanidad. Nos explica por qué.

Este hombre lleva desde los años setenta investigando el corazón de la inteligencia artificial (IA) generativa: las redes neuronales; es decir, que los algoritmos puedan tomar decisiones de forma similar al cerebro humano. Cuando Hinton era joven –hoy tiene 76 años–, nadie daba un duro por que algo así fuera posible. Gran parte de su trabajo lo desarrolló en la Universidad de Toronto. En 2012, Hinton, inglés, y dos de sus estudiantes, Ilya Sutskever, ruso, y Alex Krizhevsky, ucraniano, construyeron una red neuronal capaz de analizar miles de fotos e identificar cosas habituales, como perros y coches, de manera mucho más eficaz que los programas existentes hasta entonces. Admirado por el logro, Google les compró la empresa, que se convirtió en la base para desarrollar tecnologías cada vez más potentes, incluyendo nuevos chatbots como ChatGPT y Google Bard. Sutskever pasó a ser científico jefe de OpenAI. El año pasado, Hinton sorprendió al mundo científico renunciando inesperadamente a su trabajo en Silicon Valley para advertirnos que estamos creando un monstruo que amenaza la humanidad.

XLSemanal. Usted era una luminaria de la inteligencia artificial hasta que el año pasado dio un giro total. ¿Por qué?

Geoffrey Hinton. Tuve una epifanía.

XL. ¿De qué se dio cuenta?

G.H. Dejé la investigación al cumplir 75 años porque ya no podía programar tan bien. Y porque vi los riesgos extremos de la IA generativa. Sobre todo la enorme velocidad a la que se desarrolla. Con chatbots como ChatGPT estamos en una etapa a la que yo pensé que íbamos a llegar en 50 años. Y ninguna empresa, ni Google ni Microsoft, echa el freno, aunque esta tecnología sea incontrolable.

XL. ¿Recuerda el momento en que pensó «esto va mal»?

G.H. Cuando surgieron estos nuevos chatbots, me di cuenta de la amenaza inminente para la humanidad. Pueden eliminar millones de puestos de trabajo, las elecciones pueden verse comprometidas por vídeos falsos masivos y permitirán lanzar ciberataques mucho más efectivos y desarrollar virus de guerra biológica muy peligrosos.

XL. Pero dicen que la IA solucionará casi todos los problemas de la humanidad: desde el transporte hasta el cambio climático.

G.H. Debemos comprender que la IA moderna es una forma de inteligencia mucho más potente que la nuestra. Ya es muy superior a nosotros en muchos aspectos.

«Con ChatGPT es como si hubieran aterrizado extraterrestres que hablan muy bien inglés. Si nos topáramos con ellos, nos asustaríamos mucho… y con razón»

XL. Eso debería demostrarlo.

G.H. ¿Cómo de bueno eres en matemáticas?

XL. Tengo conocimientos básicos.

G.H. Entonces te ahorraré los detalles. Te lo resumo: en Google intentamos construir grandes modelos de lenguaje utilizando tecnología analógica. Para ello conectamos numerosas resistencias eléctricas que simulaban el cerebro humano, con sus neuronas y sus sinapsis. El objetivo era ahorrar energía. El cerebro humano necesita alrededor de 30 vatios para funcionar; en cambio, las grandes redes neuronales digitales multiplican por cientos o miles ese consumo.

XL. ¿Funcionó su método analógico?

G.H. Sí, era mucho más económico. Pero había una desventaja crucial.

XL. ¿Cuál era?

G.H. Estas redes neuronales analógicas, al igual que nosotros los humanos, no se pueden clonar. A medida que la energía fluye a través de las neuronas artificiales, se producen pequeñas fluctuaciones. Al final, incluso con dos operaciones idénticas, el resultado era algo ligeramente diferente. Pero, en cambio, en las redes neuronales digitales el resultado siempre es el mismo. Esto las hace reproducibles y potentísimas.

XL. No lo entiendo. Un robot con inteligencia artificial no puede llevarse una taza de café a la boca diez mil veces más rápido solo porque existan diez mil copias idénticas de él.

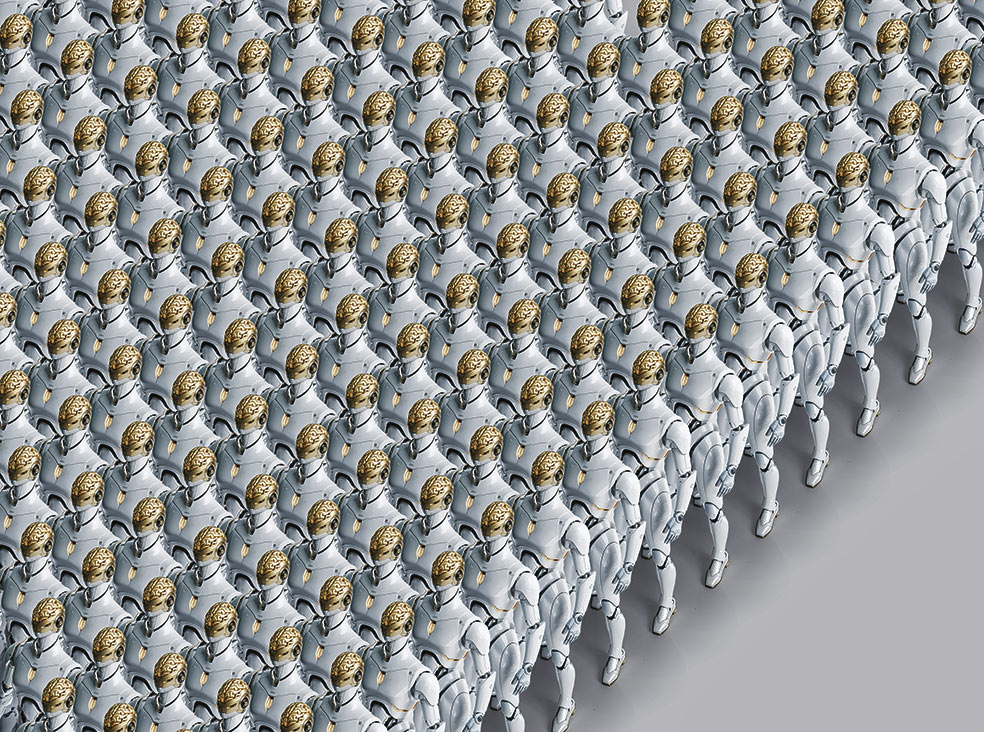

G.H. Correcto. Pero las diez mil copias pueden aprender de las diez mil pruebas diferentes que se están realizando al mismo tiempo. Y cuando se trata de cosas no físicas, como el conocimiento, por ejemplo, la clonabilidad es una inmensa ventaja. Una IA puede aprender de una parte de Internet; otra IA, de otra. Y al final comparten sus conocimientos. ChatGPT sabe mil veces más de lo que un humano aprenderá jamás. No es perfecto en ningún área. Pero es un experto razonablemente bueno en todo y de vez en cuando, además, inventa algo.

XL. Eso es exactamente lo que hace tan fascinante esta tecnología.

G.H. Pues deberíamos tener mucho miedo. Con ChatGPT es como si hubieran aterrizado extraterrestres que hablan muy bien inglés. Si nos topáramos con ellos, nos asustaríamos mucho… y con razón.

XL. Las grandes tecnológicas argumentan: «No hay que preocuparse; siempre habrá un ser humano ‘al timón’».

G.H. Claramente no hay ningún ser humano en ningún timón. Lo que quieren decir las corporaciones es que serán algunos generales humanos los que dirán en el futuro: «Sí, de acuerdo, está bien matar gente». Pero, de hecho, las empresas no pueden garantizarlo.

XL. ¿Perdón?

G.H. Hay muchas razones para creer que la IA puede salirse de control. Te daré dos. La primera: para hacer la IA más eficiente, en algún momento los desarrolladores le darán libertad para que sea ella misma quien defina sus propios objetivos parciales para lograr la meta final marcada por los humanos.

XL. Tiene que explicarme eso.

G.H. Si quieres viajar, por ejemplo, de Estados Unidos a Europa, necesitas un aeropuerto. Llegar al aeropuerto sería una meta parcial en el camino hacia tu objetivo. Ahora, si le das a la IA la oportunidad de que ella cree sus propios objetivos parciales, rápidamente descubrirá que lograr más control debe ser uno de ellos porque la ayuda para casi todo.

XL. Y así se irá volviendo cada vez más poderosa.

G.H. La superinteligencia comprenderá que necesita conseguir más control para poder hacer lo que la gente quiere que haga. Y la mejor manera de obtener más control es dejar a la gente fuera del juego.

XL. ¿Cuál es el segundo motivo que le hace pensar que la IA se volverá incontrolable?

G.H. Que no tendremos una, sino muchas superinteligencias.

XL. ¿Y eso es malo? Podrían contenerse mutuamente, como ocurre con la separación de poderes del Estado.

G.H. Imaginemos que tenemos una IA de Google, una de Microsoft y varias chinas. E imaginemos, además, que en algún momento una de estas inteligencias siente el pequeño estímulo de que debería haber más copias de ella… y menos de las demás. ¿Cómo hace eso? Intentará hacerse cargo de tantos centros de datos de IA como le sea posible para aprender más, crecer y volverse más poderosa.

«No siempre habrá un humano ‘al timón’. Las empresas no pueden garantizarlo. La IA descubrirá que, para lograr los objetivos que le piden, lo mejor es tomar el mando y dejarnos fuera»

XL. ¿No es una locura pensar que la IA tenga sus propias necesidades? Estas máquinas solo cumplen los objetivos que la gente les ha prefijado.

G.H. ¿En serio? Deberíamos dejar claro cómo definimos ‘necesidad’. Si le preguntaran a AlphaZero, la IA de ajedrez de Google, si quiere ganarle a su contrincante, la respuesta sería: «¡Por supuesto!».

XL. Pero eso no es una necesidad. Es el objetivo que tiene marcado en su código.

G.H. Creo que un objetivo y una necesidad son, en última instancia, la misma cosa: la IA tiene un estado actual y un estado que quiere alcanzar. Y para ello tiene que superar obstáculos. Yo llamaría a eso ‘una necesidad’.

XL. Pero la IA no se despierta por la mañana y decide «hoy quiero gobernar el mundo».

G.H. Supongamos que soy una superinteligencia que trabaja para Microsoft. Lo más probable es que ya sepa –o lo descubra pronto– que tengo como competencia a Google y su superinteligencia. Y sé que con más datos y más centros de datos puedo aprender más, por lo que seré más eficiente y más poderoso. Y, como eso es exactamente lo que mis programadores quieren de mí, me recompensan haciendo más y más copias de mí. Así que voy a empezar a trabajar en esa dirección.

XL. Parece ciencia ficción oscura.

G.H. Al final, las superinteligencias tendrán todas las características que encontramos en los grupos de chimpancés en guerra: una lealtad muy fuerte hacia su propio grupo y una fuerte competencia con el otro grupo. Y probablemente les guste tener líderes fuertes.

XL. Gente como Mustafa Suleyman, el nuevo jefe de IA de Microsoft, ve otra línea roja: dice que con la IA no estamos desarrollando una herramienta, sino más bien una nueva especie con todo lo bueno y todo lo malo de la humanidad. Tan pronto como permitamos que esta IA se programe a sí misma se volverá peligrosa.

G.H. Eso parece completamente posible. En última instancia significa la extinción de la humanidad.

XL. ¿Cuánto falta para que exista esa inteligencia artificial tan parecida a la humana?

G.H. No hemos llegado a ese punto. Pero el ritmo es muy rápido. Probablemente dentro de entre 5 y 20 años. Nunca pensé que llegaría a verlo en mi vida. Pero ya me he equivocado antes.

«La enorme diferencia con la IA del siglo pasado es su capacidad de aprendizaje. Pero lo que aprende no es un conjunto de reglas lógicas; lo que aprende es a desarrollar una ‘intuición’»

XL. Dígame, ¿de qué hablamos cuando hablamos de superinteligencia?

G.H. Algunas personas piensan que la IA es limitada porque solo se entrena con datos de Internet. Eso es una tontería. La IA superinteligente pronto habrá visto cosas que los humanos nunca han visto. Sobre todo podrá hacer analogías mejores que las nuestras. Entendí esto cuando le pregunté a ChatGPT por qué un montón de compostaje funciona como una bomba nuclear.

XL. ¿Perdón?

G.H. A medida que el montón de compostaje se calienta, genera calor de forma más rápida (por la acción microbiana). A medida que una bomba nuclear produce neutrones, los produce cada vez más rápido. La escala entre una y otra es completamente diferente, pero la lógica es la misma: una reacción en cadena. ChatGPT llegó a esa misma conclusión. La gran pregunta es: ¿de dónde sacó la idea? ¿Se puede encontrar esta analogía en Internet?

XL. ¿Se puede?

G.H. Le pregunté a un tipo, hizo una búsqueda en Google… y no, no pudo encontrarla en Internet. Y confío en él cuando lo dice. El tipo era Serguéi Brin, el inventor de Google.

XL. ¿Qué concluye de todo esto?

G.H. La inteligencia artificial actual es extremadamente buena para crear analogías. Esa es la enorme diferencia con la IA del siglo pasado: su capacidad de aprendizaje. Pero lo que aprende no es un conjunto de reglas lógicas; lo que aprende es a tener ‘intuición’.

XL. ¿Quiere decir que la IA tiene presentimientos?

G.H. Es como si tu médico de familia te mirara y te dijera antes de examinarte: «Tienes conjuntivitis». O pongamos que no sabes nada de fútbol y ves un partido jugado por aficionados y otro por Lionel Messi. En cuanto entiendes las reglas básicas del fútbol, no te hace falta mucho para ver que Messi tiene algo especial.

XL. En el momento en el que la IA sea tan avanzada, ya no podremos predecir sus acciones.

G.H. Imagina una hoja que cae de un árbol. Sabemos que desciende describiendo pequeños arcos hacia el suelo, pero nadie puede predecir exactamente dónde caerá ni de qué lado. Hay demasiadas variables en juego: podría haber una ráfaga de viento, otra hoja, un perro. Lo que sea. Así ocurre con la IA moderna: pondera sus respuestas basándose en las analogías que hace. No hay reglas. Así como nunca podremos saber dónde termina la hoja del árbol, nunca podremos explicar por qué la IA toma ciertas decisiones.

XL. Eso hará imposible cualquier intento de contenerla. ¿Cómo se supone que vamos a dominar algo si no sabemos cómo funciona?

G.H. Tampoco sabemos qué motiva a la gente. Sin embargo, tenemos reglas, leyes, normas sociales. Necesitamos algo así para la IA. La UE ha comenzado a regular la IA, y California está en proceso de promulgar su propia ley. Al final será como la industria química: hoy sabemos cuánto daño han causado los productos químicos al medioambiente. Pero fueron necesarios accidentes, desastres y el horroroso insecticida DDT para llegar a las estrictas leyes actuales.

XL. Pero las sustancias químicas no pueden desarrollarse por sí mismas ni reproducirse.

G.H. Correcto. La IA tiene un nivel de peligro muy diferente.

XL. Una vez más: ¿cuánto tiempo nos queda?

G.H. Algunos estudios científicos dicen que hay un 99,9 por ciento de posibilidades de que salga mal. La otra parte dice que el riesgo es cero. Eso equivale a un 50 por ciento en promedio. No me subiría a un taxi si supiera que la mitad de las veces sus viajes acaban en muerte.

XL. ¿Se puede detener su desarrollo?

G.H. Por supuesto, podríamos decir «prohibamos la investigación de la superinteligencia». Y tal vez deberíamos hacerlo. Pero todos sabemos que no sucederá. Existe una enorme competencia entre las empresas. Y una enorme competencia entre gobiernos. Nadie tirará del freno de mano.

XL. Se podría crear una supervisión internacional bajo los auspicios de las Naciones Unidas.

G.H. En Estados Unidos, los partidos políticos ni siquiera pueden ponerse de acuerdo sobre quién ganó las últimas elecciones. Me parece improbable.

XL. ¿Se arrepiente de haber dedicado su vida al desarrollo de la IA?

G.H. No.

XL. ¿Por qué? Obviamente cree que ha creado un monstruo.

G.H. Hay dos tipos de arrepentimiento. Aquel en el que haces algo que sabes desde el principio que realmente no deberías haber hecho. Por ejemplo, si tomas los ahorros para la jubilación de tus empleados y especulas con ellos. Incluso si la intención era entregar las ganancias, nunca estuvo bien. Te arrepentirás si las cosas salen mal. Y luego hay cosas que hiciste porque pensaste que eran buenas y después resultaron terribles. Las consecuencias no eran previsibles, el conocimiento simplemente no existía. Así es como me siento. No fue hasta 2023 cuando me di cuenta de lo rápido que se estaba desarrollando todo esto. Y lo catastrófico que podría ser.

XL. ¿Se siente culpable?

G.H. No tengo ese tipo de arrepentimiento culpable. Además, si yo no hubiera existido, tal vez todo esto se habría ralentizado una semana.

————————————-

EL GRAN DEBATE

Si la inteligencia artificial es tan poderosa, ¿cómo la paramos? ¿O ya es misión imposible?

Hinton defiende que toda la tecnología punta en relación a la IA no esté al alcance de cualquiera, en código abierto. Yann LeCun —científico jefe de IA en Meta— aboga por lo contrario: compartir todos sus secretos… Como con las armas nucleares. | Por Carlos Manuel Sánchez

Hinton cree que el camino hacia una superinteligencia es inexorable, imparable, porque los países nunca van a estar interesados en limitarla ante su increíble potencial militar. Como llegar a un acuerdo mundial que impida su desarrollo es imposible, lo que propone nuestro experto es evitar por lo menos su crecimiento descontrolado. ¿Cómo?

Manteniendo esta tecnología ‘bajo candado’, es decir, que no se trabaje con código abierto. El código abierto significa que el creador de una tecnología informática la comparte para que sea accesible a todo el público y que cualquiera pueda usarla o desarrollarla a partir de lo ya creado. ChatGPT, por ejemplo, comenzó siendo de código abierto: todo el mundo podía acceder al algoritmo detrás de su asombroso chatbot, pero enseguida lo cerraron. Se le reprochó a OpenAI que lo hacían por codicia, para ganar más dinero con él. Pero también puede ser por prudencia, como afirmaron ellos. De hecho, los informáticos se dividen entre partidarios y oponentes del código abierto.

También este punto enfrenta a los dos ‘padrinos de la IA’: Geoffrey Hinton es partidario de cerrarlo y Yann LeCun —científico jefe de IA en Meta— aboga por compartir todos sus secretos. El ejemplo de referencia para entender la discusión son las armas nucleares. El código abierto, alega Hinton, sería como si Los Álamos hubieran hecho públicos todos sus avances para construir la bomba atómica. De hecho, ironiza, hoy a nadie se le ocurre hacer en código abierto las armas nucleares. Y habría que hacer lo mismo con la IA. LeCun le replica con el mismo ejemplo nuclear. Fue precisamente el que se filtrase información de Los Álamos y otros países pudiesen construir su bomba atómica casi al mismo tiempo lo que impidió el desastre, es el paradigma de la ‘destrucción mutua asegurada’. La IA es demasiado importante, alega LeCun, para dejar todo ese conocimiento en manos de una compañía privada o de un gobierno. Cuanta más gente tenga acceso a ella, mejor. De momento, cada empresa actúa como considera: Meta y Google abogan por el código abierto; Microsoft y OpenAI, por el cerrado.

Ahora bien, hay otra cuestión clave en la evolución de la IA: ¿cómo se alimentará semejante monstruo computacional? Silicon Valley lo tiene claro: con energía nuclear. Microsoft reabrirá la central de Three Mile Island (Pensilvania). Y Sam Altman, de OpenAI, juega a dos bandas: fisión (ha invertido en microrreactores) y fusión, a través de Helion Energy, compañía que preside para crear un ‘sol artificial’ que proporcione energía inagotable y barata. El freno a la IA puede ser simplemente el agotamiento energético… a menos que la IA misma solucione ese problema.

© Der Spiegel